Jun 18, 2025

Faradilla A.

7menit Dibaca

Ollama adalah tool canggih untuk menjalankan Large Language Model (LLM) secara lokal. Tool ini memudahkan para developer, data scientist, dan pengguna teknis untuk mengustomisasi LLM sesuai dengan kebutuhan spesifik mereka.

Meskipun Ollama bisa digunakan dengan GUI pihak ketiga seperti Open WebUI, Anda juga bisa menjalankannya melalui CLI (Command-Line Interface) untuk mendokumentasikan respons ke dalam file dan mengotomatiskan alur kerja menggunakan skrip.

Di tutorial ini, Anda akan mempelajari cara menggunakan Ollama melalui CLI, mulai dari perintah-perintah dasarnya, berinteraksi dengan LLM, hingga mengotomatiskan tugas dan meluncurkan model Anda sendiri. Yuk, simak panduannya di bawah ini!

Cara setting Ollama di CLI

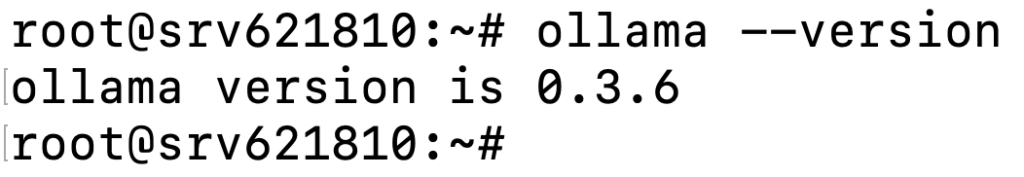

Sebelum menggunakan Ollama di CLI, pastikan Anda sudah berhasil menginstalnya di sistem. Lakukan verifikasi dengan membuka terminal dan menjalankan perintah berikut:

ollama --version

Anda akan melihat output seperti ini:

Selanjutnya, pelajari beberapa perintah penting Ollama di bawah ini:

| Perintah | Deskripsi |

ollama serve |

Memulai Ollama di sistem lokal Anda. |

ollama create <new_model> |

Membuat model baru dari model yang sudah ada untuk penyesuaian atau pelatihan. |

ollama show <model> |

Menampilkan detail tentang model tertentu, seperti konfigurasi dan tanggal rilis. |

ollama run <model> |

Menjalankan model yang ditentukan agar siap digunakan. |

ollama pull <model> |

Mendownload model yang ditentukan ke sistem Anda. |

ollama list |

Mencantumkan semua model yang sudah didownload. |

ollama ps |

Menampilkan model yang sedang berjalan. |

ollama stop <model> |

Menghentikan model yang sedang berjalan, sesuai yang ditentukan. |

ollama rm <model> |

Menghapus model dari sistem, sesuai yang ditentukan. |

Penggunaan dasar Ollama di CLI

Bagian ini akan membahas penggunaan utama Ollama CLI, mulai dari berinteraksi dengan model hingga menyimpan output ke dalam file.

Menjalankan LLM

Untuk mulai menggunakan LLM di Ollama, Anda perlu mendownload model yang diinginkan terlebih dahulu menggunakan perintah pull. Sebagai contoh, untuk menggunakan model Llama 3.2, jalankan perintah berikut:

ollama pull llama3.2

Tunggu hingga download selesai. Lama prosesnya bisa berbeda-beda tergantung pada ukuran file model yang didownload.

Tips berguna

Apabila tidak yakin model mana yang harus didownload, kunjungi library model resmi Ollama. Library ini menyediakan informasi penting untuk setiap model, termasuk opsi penyesuaian, dukungan bahasa, dan skenario penggunaan yang direkomendasikan.

Setelah model berhasil didownload, Anda bisa langsung menjalankannya dengan prompt spesifik seperti berikut:

ollama run llama3.2 "Explain the basics of machine learning."

Output yang dihasilkan kira-kira akan seperti ini:

Atau, jalankan model tanpa perintah untuk memulai sesi interaktif:

ollama run llama3.2

Dalam mode ini, Anda bisa memberikan pertanyaan atau instruksi, lalu LLM akan menghasilkan respons. Anda juga bisa bertanya lebih lanjut untuk mendapatkan jawaban yang mendetail atau mengklarifikasi jawaban yang diberikan, seperti pada contoh prompt berikut:

Can you elaborate on how machine learning is used in the healthcare sector?

Setelah selesai, ketik:

/bye

Sesi Anda akan diakhiri, dan Anda diarahkan kembali ke tampilan terminal biasa.

Melatih LLM

Model open-source terlatih seperti Llama 3.2 sebenarnya sudah cukup bagus untuk tugas-tugas umum, seperti membuat konten. Namun, model ini mungkin tidak selalu optimal untuk kebutuhan yang lebih spesifik. Untuk meningkatkan akurasi model terkait topik tertentu, Anda perlu melatihnya dengan data yang lebih relevan.

Perlu diingat bahwa LLM memiliki keterbatasan memori jangka pendek, yang berarti data pelatihannya hanya akan disimpan selama sesi percakapan aktif. Apabila Anda mengakhiri suatu sesi dan memulai yang baru, model ini tidak akan mengingat informasi pelatihan sebelumnya.

Untuk melatih model ini, mulai sesi interaktif lalu ketikkan perintah berikut:

Hey, I want you to learn about [topic]. Can I train you on this?

Anda kemudian akan mendapatkan respons seperti di bawah ini:

Setelah itu, berikan informasi dasar tentang topik Anda agar model ini bisa memahaminya dengan lebih baik:

Untuk melanjutkan pelatihan dan memberikan lebih banyak informasi, mintalah model ini untuk mengajukan pertanyaan tentang topik Anda, misalnya:

Can you ask me a few questions about [topic] to help you understand it better?

Setelah model memperoleh cukup informasi tentang topik yang dibahas, Anda bisa mengakhiri pelatihan, lalu melakukan uji coba untuk memastikan model bisa mengingat dan menerapkan pengetahuan yang baru dipelajari.

Dengan Ollama, Anda bisa meminta LLM untuk melakukan tugas menggunakan file, seperti meringkas teks atau menganalisis informasi. Hal sangat berguna untuk dokumen panjang, karena Anda tidak perlu menyalin dan menempelkan teks saat memberikan instruksi pada model ini.

Sebagai contoh, kalau Anda memiliki file bernama input.txt yang berisi informasi yang ingin Anda rangkum, jalankan perintah berikut:

ollama run llama3.2 "Summarize the content of this file in 50 words." < input.txt

Model ini akan membaca isi file dan menghasilkan ringkasan:

Dengan Ollama, Anda juga bisa mencatat respons model ke dalam file sehingga lebih mudah ditinjau atau diedit lebih lanjut. Berikut contoh mengajukan pertanyaan kepada model ini dan menyimpan outputnya ke dalam file:

ollama run llama3.2 "Tell me about renewable energy."> output.txt

Respons model akan disimpan dalam file dengan format .txt:

Penggunaan tingkat lanjut Ollama di CLI

Setelah memahami penggunaan dasar Ollama di CLI, sekarang mari pelajari contoh penggunaan tingkat lanjut Ollama melalui CLI.

Membuat model khusus

Dengan menjalankan Ollama melalui CLI, Anda bisa membuat model khusus sesuai dengan kebutuhan spesifik Anda.

Untuk melakukannya, Anda perlu membuat Modelfile, yaitu blueprint model kustom Anda. File ini menentukan pengaturan utama seperti model dasar, parameter yang perlu disesuaikan, dan cara model akan merespons perintah.

Ikuti langkah-langkah berikut untuk membuat model kustom di Ollama:

1. Buat Modelfile baru

Gunakan editor teks seperti nano untuk membuat Modelfile baru. Dalam contoh ini, kita akan menamai file dengan nama custom-modelfile:

nano custom-modelfile

Selanjutnya, salin dan tempelkan template Modelfile dasar ini, yang akan kita sesuaikan di langkah berikutnya:

# Use Llama 3.2 as the base model

FROM llama3.2

# Adjust model parameters

PARAMETER temperature 0.7

PARAMETER num_ctx 3072

PARAMETER stop "assistant:"

# Define model behavior

SYSTEM "You are an expert in cyber security."

# Customize the conversation template

TEMPLATE """{{ if .System }}Advisor: {{ .System }}{{ end }}

Client: {{ .Prompt }}

Advisor: {{ .Response }}"""

2. Sesuaikan file Model

Beberapa elemen penting yang bisa Anda sesuaikan dalam Modelfile antara lain:

- Model dasar (FROM). Menetapkan model dasar yang akan digunakan untuk instance khusus Anda. Misalnya, Anda bisa memilih Llama 3.2:

FROM llama3.2

- Parameter (PARAMETER). Mengatur perilaku model, seperti:

- Temperature. Mengatur kreativitas model. Nilai lebih tinggi (misalnya 1.0) membuat model lebih kreatif, sementara nilai lebih rendah (misalnya 0.5) membuatnya lebih fokus.

PARAMETER temperature 0.9

- Context window (num_ctx). Menentukan berapa banyak teks sebelumnya yang digunakan sebagai konteks.

PARAMETER num_ctx 4096

- System message (SYSTEM). Menentukan bagaimana model harus bertindak. Anda bisa memintanya untuk berperan sebagai karakter tertentu atau menghindari menjawab pertanyaan yang tidak relevan:

SYSTEM “You are an expert in cyber security. Only answer questions related to cyber security. If asked anything unrelated, respond with: ‘I only answer questions related to cyber security.’"

- Template (TEMPLATE). Menyesuaikan struktur interaksi antara pengguna dan model. Misalnya:

TEMPLATE """{{ if .System }}<|start|>system

{{ .System }}<|end|>{{ end }}

<|start|>user

{{ .Prompt }}<|end|>

<|start|>assistant

"""

Setelah selesai melakukan penyesuaian, simpan file dan keluar dari nano dengan menekan Ctrl + X, lalu tekan Y, dan tekan Enter.

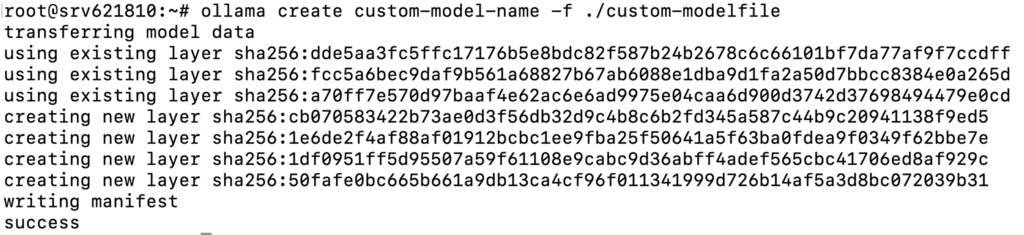

3. Buat dan jalankan model khusus

Setelah Modelfile siap, gunakan perintah di bawah ini untuk membuat model berdasarkan file tersebut:

ollama create custom-model-name -f ./custom-modelfile

Anda akan melihat output yang menunjukkan bahwa model berhasil dibuat.

Setelah itu, jalankan model seperti biasa:

ollama run custom-model-name

Langkah ini akan memulai model dengan semua penyesuaian yang telah Anda terapkan, dan Anda bisa langsung berinteraksi dengannya:

Anda bisa terus menyempurnakan Modelfile dengan mengubah parameter, mengedit pesan sistem, menambah template yang lebih canggih, atau bahkan menyertakan data Anda sendiri. Setelah itu, simpan perubahan dan jalankan kembali model untuk melihat efek dari perubahan yang dilakukan.

Mengotomatiskan tugas dengan skrip

Mengotomatiskan tugas yang berulang di Ollama bisa menghemat waktu dan meningkatkan konsistensi alur kerja Anda. Dalam hal ini, gunakan bash script untuk menjalankan perintah secara otomatis, atau gunakan cron job untuk menjadwalkan tugas agar dijalankan pada waktu tertentu. Berikut caranya:

Buat dan jalankan bash script

Anda bisa membuat bash script yang menjalankan perintah Ollama. Berikut caranya:

- Buka editor teks dan buat file baru bernama ollama-script.sh:

nano ollama-script.sh

- Tambahkan perintah Ollama yang diperlukan. Misalnya, untuk menjalankan model dan menyimpan output ke sebuah file:

#!/bin/bash # Run the model and save the output to a file ollama run llama3.2 "What are the latest trends in AI?" > ai-output.txt

- Agar skrip dapat dieksekusi, berikan izin yang sesuai: memberikan izin yang benar:

chmod +x ollama-script.sh

- Jalankan skrip langsung dari terminal:

./ollama-script.sh

Atur cron job untuk mengotomatiskan tugas

Anda juga bisa menggabungkan skrip ini dengan cron job untuk menjadwalkan tugas agar dijalankan secara otomatis. Berikut cara mengatur cron job untuk menjalankan skrip Ollama pada waktu tertentu:

- Buka editor crontab dengan mengetik:

crontab -e

- Tambahkan baris yang menentukan jadwal dan skrip yang ingin dijalankan. Misalnya, untuk menjalankan skrip setiap hari Minggu pada tengah malam:

0 0 * * 0 /path/to/ollama-script.sh

- Simpan dan keluar dari editor setelah menambahkan cron job.

Contoh penggunaan umum untuk CLI

Berikut beberapa contoh penggunaan Ollama di CLI yang bisa Anda terapkan dalam berbagai kasus.

Pembuatan teks

Dengan menggunakan model yang sudah dilatih, Anda bisa membuat rangkuman, menghasilkan konten, atau menjawab pertanyaan tertentu.

- Meringkas file teks yang besar:

ollama run llama3.2 "Summarize the following text:" < long-document.txt

- Menghasilkan konten seperti postingan blog atau deskripsi produk:

ollama run llama3.2 "Write a short article on the benefits of using AI in healthcare."> article.txt

- Menjawab pertanyaan spesifik untuk membantu penelitian:

ollama run llama3.2 "What are the latest trends in AI, and how will they affect healthcare?"

Pemrosesan, analisis, dan prediksi data

Ollama juga memungkinkan Anda menangani berbagai tugas pemrosesan data, seperti klasifikasi teks, analisis sentimen, dan prediksi.

- Mengelompokkan teks ke dalam sentimen positif, negatif, atau netral:

ollama run llama3.2 "Analyze the sentiment of this customer review: 'The product is fantastic, but delivery was slow.'"

- Mengategorikan teks ke dalam kategori yang telah ditentukan:

ollama run llama3.2 "Classify this text into the following categories: News, Opinion, or Review." < textfile.txt

- Memprediksi hasil berdasarkan data yang disediakan:

ollama run llama3.2 "Predict the stock price trend for the next month based on the following data:" < stock-data.txt

Integrasi dengan tool eksternal

Penggunaan Ollama CLI juga mencakup integrasi dengan tool eksternal, memungkinkan Anda mengotomatiskan pemrosesan data dan meningkatkan kemampuan aplikasi lain.

- Mengintegrasikan Ollama dengan API pihak ketiga untuk mengambil data, memprosesnya, dan memberikan hasil:

curl -X GET "https://api.example.com/data" | ollama run llama3.2 "Analyze the following API data and summarize key insights."

- Menggunakan kode Python untuk menjalankan subproses dengan Ollama:

import subprocess result = subprocess.run(['ollama', 'run', 'llama3.2', 'Give me the latest stock market trends'], capture_output=True) print(result.stdout.decode())

Kesimpulan

Melalui artikel ini, Anda sudah mempelajari berbagai hal penting dalam menggunakan Ollama melalui CLI, termasuk menjalankan perintah dasar, berinteraksi dengan model, dan menyimpan respons model ke dalam file.

Dengan CLI, Anda juga bisa melakukan tugas yang lebih canggih, seperti membuat model kustom, mengotomatiskan alur kerja dengan skrip dan cron job, serta mengintegrasikan Ollama dengan berbagai tool eksternal.

Setelah ini, Anda bisa mencoba berbagai fitur kustomisasi Ollama untuk memaksimalkan penggunaannya dalam proyek-proyek AI Anda. Apabila masih memiliki pertanyaan atau ingin berbagi pengalaman Anda menggunakan Ollama di CLI, jangan ragu untuk menyampaikannya lewat komentar, ya.

Tanya jawab (FAQ) tutorial Ollama CLI

Apa keuntungan menggunakan Ollama di CLI?

Dengan menggunakan Ollama melalui CLI, Anda bisa menjalankan model, menghasilkan teks, melakukan pemrosesan data seperti analisis sentimen, mengotomatiskan alur kerja menggunakan skrip, membuat model kustom, dan mengintegrasikan Ollama dengan tool eksternal atau API untuk aplikasi tingkat lanjut.

Bagaimana cara menginstal model untuk Ollama di CLI?

Untuk menginstal model melalui CLI, pastikan Anda telah mendownload Ollama di sistem Anda. Setelah itu, gunakan perintah ollama pull diikuti dengan nama model. Contohnya, untuk menginstal Llama 3.2, jalankan: ollama pull llama3.2.

Apakah bisa menggunakan model multimodal dalam versi CLI?

Meskipun secara teknis Anda bisa menggunakan model multimodal seperti LlaVa di Ollama CLI, prosesnya mungkin agak repot karena CLI dioptimalkan untuk tugas-tugas berbasis teks. Anda bisa menggunakan Ollama dengan tool GUI untuk menangani pekerjaan yang berhubungan dengan visual.

Tutorial Ollama CLI: cara menjalankan Ollama melalui terminal